Derfor lavede vi denne deepfake

By: Francesca Panetta and Halsey Burgund

Mange mennesker har spurgt os som instruktører, hvorfor vores projekt — en video, der foregiver at vise en alternativ virkelighed, hvor månelandingen i 1969 mislykkedes, og præsident Richard Nixon sørgede over tabet af to ikoniske astronauter — ikke er misinformation i sig selv. Føjer vi ikke bare til de mange konspirationsteorier om månelandingen?

Vores svar er et eftertrykkeligt nej. Som multimediekunstnere og journalister, der har arbejdet et årti i et skiftende medielandskab, mener vi, at information, der præsenteres som usand i en kunstnerisk og uddannelsesmæssig sammenhæng, ikke er misinformation. Faktisk kan det være styrkende: At opleve brugen af nye teknologier på en gennemskuelig måde vil følge seerne fremover og gøre dem mere forsigtige i forhold til, hvad de ser i fremtiden. Ved at bruge de mest avancerede teknikker, der er til rådighed, og ved at insistere på at skabe en video ved hjælp af både syntetisk grafik og syntetisk lyd (en “komplet deepfake”), sigter vi mod at vise, hvor denne teknologi er på vej hen — og hvad nogle af de vigtigste konsekvenser kan være.

SKUESPILLEREN LEWIS D. WHEELER BLIVER FILMET, MENS HAN HOLDER BEREDSKABSTALEN. ALLE STUDIEFOTOS AF CHRIS BOEBEL.

Efter at have skabt komplekse interaktive medier, virtual reality-oplevelser og lydbaserede augmented reality-platforme, troede vi, at det ville være let at lave en deepfake. Normalt koder og konstruerer vi omhyggeligt vores projekter selv, da vi begge er pedantiske med detaljer. Men denne gang skulle vi uddelegere arbejdet til kunstige intelligenser (AI’er). Vi kunne læne os tilbage, slappe af og få arbejdet gjort for os af en smart, højtuddannet sort boks.

Men vi tog fejl.

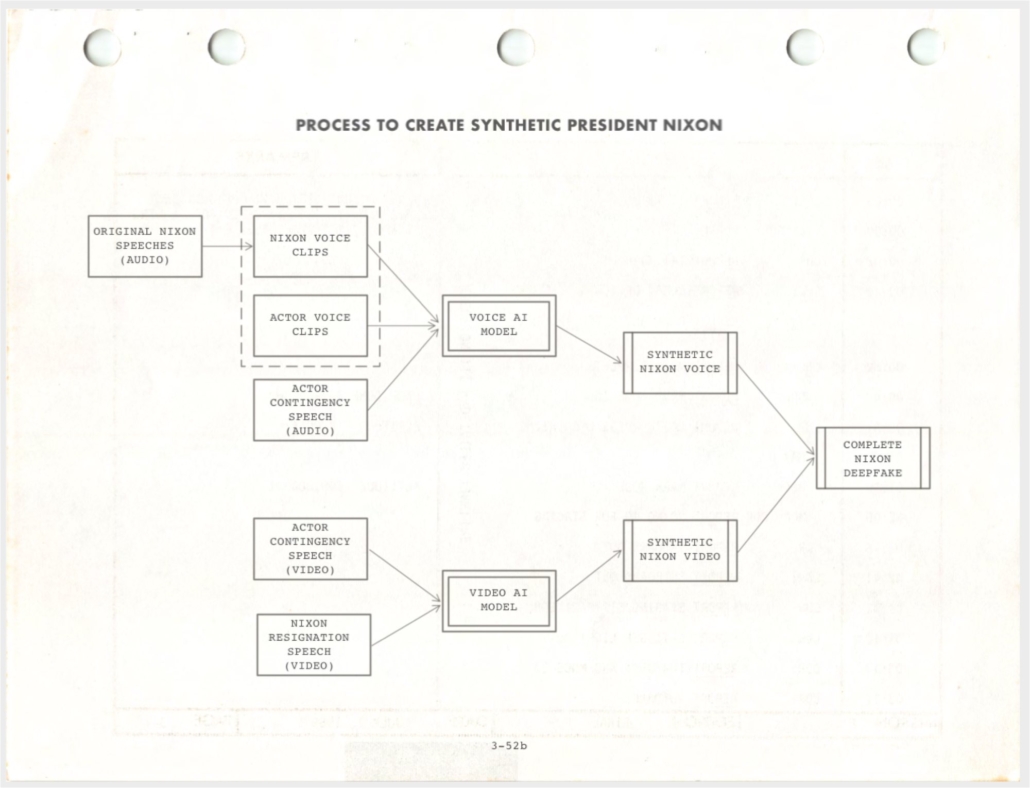

Først og fremmest var det ikke én AI, men to AI’er. Den første for at bygge en model til det visuelle — at få Richard Nixon til at se ud, som om han var i Det Ovale Kontor og læste talen højt; hans læber skulle forme de ord, han aldrig sagde. Den anden skulle bygge den syntetiske Nixon-stemme, så ordene, der stammer fra hans perfekt bevægende læber, ville lyde og føles, som om Nixon leverede dem selv.

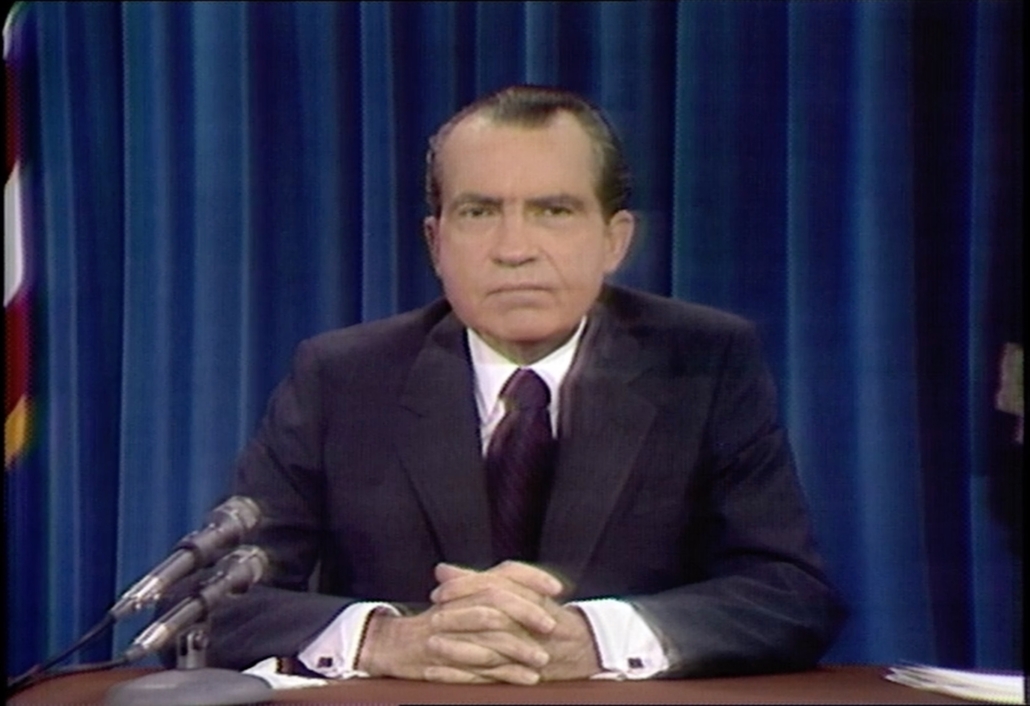

VIDEO-STILLBILLEDE AF PRÆSIDENT NIXON I DET OVALE KONTOR, HVOR HAN HOLDER EN TALE OM VIETNAMKRIGEN (KREDITERING: DET HVIDE HUS)

Vi gjorde vores research og udvalgte to virksomheder at samarbejde med: Canny AI, et israelsk firma, der udfører udskiftning af videodialog, og Respeecher, et ukrainsk firma med speciale i tale-til-tale syntetisk stemmeproduktion. Canny bruger primært sin teknologi til at læbe-synkronisere indhold, der er eftersynkroniseret til andre sprog, og reducere omkostningerne til vidoeoptagelser. Respeecher får sin teknologi brugt til historiske rekonstruktioner og i Hollywood-produktioner.

Vi gik i gang.

VISUEL PRODUKTION

Til det visuelle var det første skridt at vælge en video af en rigtig tale holdt af den rigtige Richard Nixon, som vi kunne bruge som udgangspunkt. Derefter ville vi erstatte hans mundbevægelser med dem, der holdt beredskabstalen. Vores deepfake-video ville altså være denne video med mundbevægelserne ændret og lyden udskiftet, sammen med noget af Nixons jakkesæt, hans hals og hans hage.

SKUESPILLER LEWIS D. WHEELER HOLDER BEREDSKABSTALEN I STUDIET

Så hvis Nixon blinkede i den oprindelige tale, ville han blinke i vores deepfake; hvis han så ned på sit manuskript i det originale bånd, ville han se ned i vores. “Hvad med munden?” spurgte vi Omer Ben Ami på Canny AI. “Hvis mund vil man se?” “Du vil se Nixons mund, men den bevæger sig, som om den holdt beredskabstalen,” svarede han.

Vi gennemsøgte timevis af Nixons Vietnam-taler og ledte efter et to minutters klip, hvor hans gestik og bevægelser passede perfekt sammen med den optagelse af beredskabstalen, som vores skuespiller lavede. Bladren i papirer, hovedbevægelser, håndbevægelser, var nødt til at passe troværdigt til vores nye tale. Vi sluttede med Nixons fratrædelsesudsendelse. Det var indrammet af flagene, havde en flot zoom-in, og Nixon viste visuelt følelser.

PRÆSIDENT NIXON HOLDT MANGE FORSKELLIGE TALER I DET OVALE KONTOR, HVORFRA VI VALGTE AFSKEDSTALEN SOM VORES “MÅL”-VIDEO (KREDITERING: DOMINIC SMITH)

LYDPRODUKTION

Nu til stemmen. Vi vidste, at vi skulle producere et stort sæt træningsdata, som AI’en kunne bruge til at generere vores syntetiske stemme. Respeecher fortalte os, at vi skulle finde en skuespiller, der var villig til at lytte til tusindvis af små klip af Nixon og gentage hver enkelt med samme intonation og timing. Vi afspillede så et klip for vores skuespiller, og derefter optog vi ham, mens han sagde det samme. Når vi var tilfredse med intonationen, gik vi videre til den næste. Vi gjorde dette igen og igen, indtil vi havde to til tre timers parallelle data optaget.

SKUESPILLER LEWIS D. WHEELER OPTAGER NIXON-KLIP TIL TRÆNINGSMATERIALET

“Hvilken slags skuespiller skal vi booke?” spurgte vi Dmytro på Respeecher. “Kunne jeg måske finde ud af det her?” sagde Fran og meldte sig frivilligt. “Nej, det går ikke med en brite. Skuespilleren skal have en lignende accent og skal ideelt set være mand,” fortalte han os. Skuespilleren behøvede ikke at være på samme alder eller af samme etnicitet, og det var afgørende, at skuespilleren IKKE skulle imitere Nixon. Det ville være katastrofalt, da de ikke ville være i stand til at holde det gående i op til tre dage i træk.

Det var en hård uge i lydstudiet. Vores skuespiller, Lewis D. Wheeler, sled som en hest. Sætning efter sætning gentog han og forsøgte at få rytmen og kadencen rigtigt. Han forsøgte aldrig at antage en Nixon-accent undtagen efter opfordning, når vi alle sammen trængte til et grin!

Ud over Nixon-fragmenterne optog vi også 20 fulde optagelser af beredskabstalen i lyd og video. Disse skulle bruges af Canny til at kortlægge mundbevægelserne og til at lave udførelsen af den nye syntetiske tale, der skulle produceres af Respeecher.

Det tog tre uger at bygge lydmodellen, hovedsageligt fordi al den kildelyd, der blev brugt til at træne modellen, blev optaget for 50 år siden og derfor langt fra var ideel. Først lød det noget dæmpet, så Respeecher eksperimenterede med forskellige teknikker, herunder overførselslæring, og lavede nogle afgørende forbedringer. Til sidst var vi imponerede over, hvor naturtro den syntetiske tale lød.

Vi fik det visuelle tilbage fra Omer på Canny og satte det hele sammen — lyd og video, billede for billede — for at danne vores “komplette deepfake”.

FORENKLET PROCES TIL AT SKABE EN “KOMPLET DEEPFAKE” MED LYD OG BILLEDER (KREDITERING: HALSEY BURGUND)

Zao-appen, der skabte overskrifter i sommeren 2019, fik det oprindeligt til at virke, som om vi havde været i stand til at gøre dette selv med vores telefoner, men det var langt fra virkeligheden. Det tog i alt tre måneder at lave vores seksminutters video. Den erkendelse har faktisk været betryggende. At lave en deepfake af høj kvalitet er stadig ikke let. Forskere forudsiger dog, at manipulerede billeder og videoer, der ser “helt ægte” ud, vil være mulige for almindelige mennesker at skabe inden for kort tid.

Det er bekymrende, hvor let man kan skabe en overbevisende deepfake i et medielandskab, der i forvejen er uroligt. Med vores egen deepfake har vi vist seerne, hvor avanceret teknologien er blevet. Men også gjort dem klar til at møde mere sofistikerede deepfakes, der uden tvivl vil cirkulere i nærmeste fremtid. Hvis nogen husker på, hvor troværdig vores video var, og efterfølgende ser med mere kritiske øjne på deres Facebook-feed, så er vi lykkedes.